网络安全

python零基础教程

emmc

学生个人网页制作

JDK17.0.2

cloudera

DBA

Junit的特点

盒子模型

界面开发

UI开发

短时傅里叶变换

java开发平台

antdb

高频交易

onnx

signal

微信扫码登录

mfc

Sequential

train

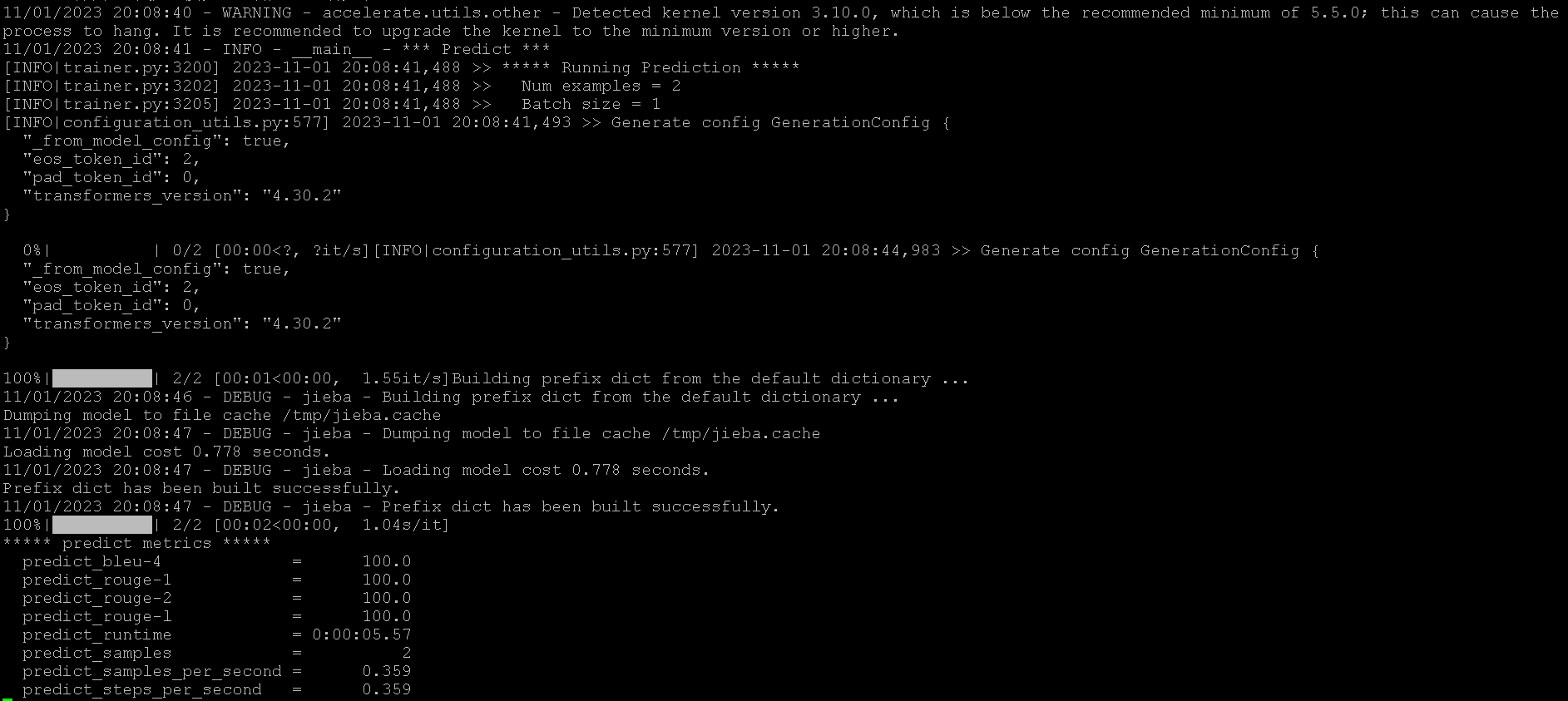

2024/4/28 7:48:45【ChatGLM2-6B】P-Tuning训练微调

机器配置

阿里云GPU规格ecs.gn6i-c4g1.xlargeNVIDIA T4显卡*1GPU显存16G*1

准备训练数据

进入/ChatGLM-6B/ptuningmkdir AdvertiseGencd AdvertiseGen上传 dev.json 和 train.json内容都是

{"content": "你是谁", "summary": "你好&…

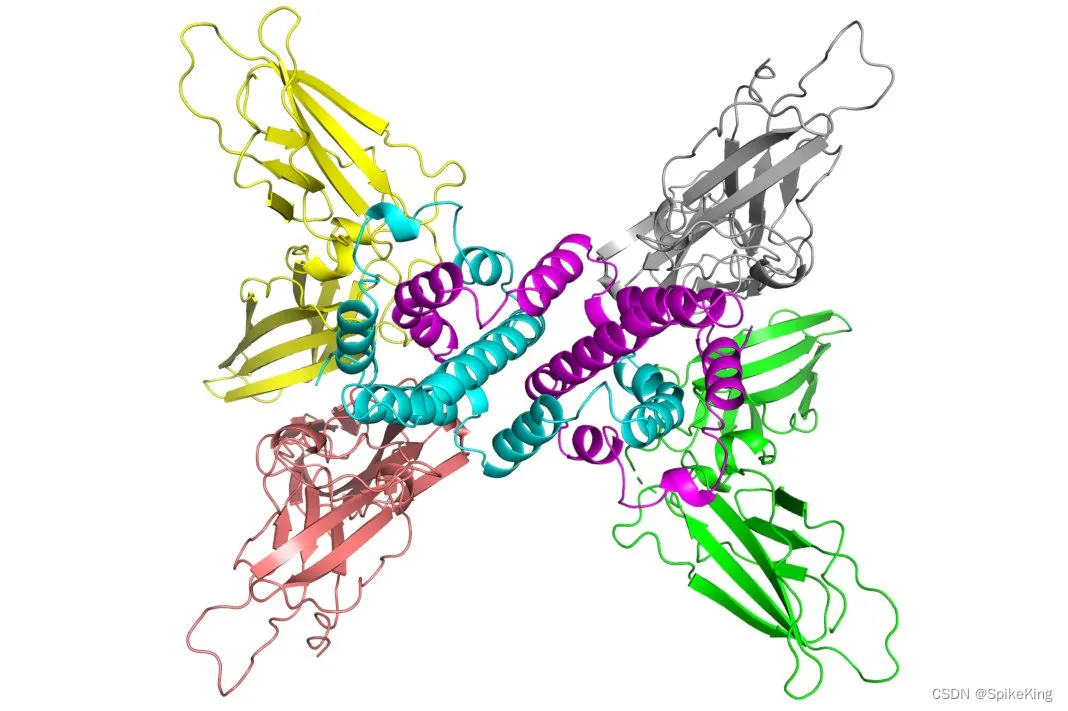

PSP - 蛋白质结构预测 OpenFold Multimer 重构训练模型的数据加载

欢迎关注我的CSDN:https://spike.blog.csdn.net/ 本文地址:https://spike.blog.csdn.net/article/details/132602155 OpenFold Multimer 在训练过程的数据加载时,需要将 MSA 与 Template 信息转换成 Feature,再进行训练࿰…

TensorFlow-Keras 1.Train And Evaluate - Demo

TensorFLow Kears 使用 Train 以及 Evaluate,以下代码基于tensorflow 2.0 版本,Conda 3.7环境。

Tips:

需要提前导入的类

import numpy as np

import tensorflow as tf

from tensorflow import keras

from tensorflow.keras import layers 一.初始化m…

大模型:如何利用旧的tokenizer训练出一个新的来?

背景:

我们在用chatGPT或者SD的时候,发现如果使用英语写提示词得到的结果比我们使用中文得到的结果要好很多,为什么呢?这其中就有一个叫做tokenizer的东西在作怪。

训练一个合适的tokenizer是训练大模型的基础,我们既…

在PyTorch里面利用transformers的Trainer微调预训练大模型

背景

transformers提供了非常便捷的api来进行大模型的微调,下面就讲一讲利用Trainer来微调大模型的步骤

第一步:加载预训练的大模型

from transformers import AutoModelForSequenceClassificationmodel AutoModelForSequenceClassification.from_pr…